Снаружи любой дата-центр Facebook выглядит как большой склад или даже сарай. Например, площадь этого центра в Северной Каролине (США) — 27 000 кв. метров.

Не все пространство внутри занято серверами. Еще там работают люди, которые следят за "здоровьем" машин. Тот факт, что Facebook использует собственную инфраструктуру, позволяет компании ежегодно экономить 2 млрд. долларов США. Именно на столько больше она бы платила, если бы арендовала мощности.

Все серверы внутри дата-центров разработаны самой Facebook. А вот оборудование для управления самими центрами, системы питания и охлаждения, сетевое оборудование — стороннее. Эти стойки, кстати, стоят внутри шведского дата-центра Facebook в Лулео, городке размером с Елгаву.

Это открытая стойка. Компоненты выглядят одинаково потому, что они одинаковые — сотни, тысячи, десятки тысяч абсолютно однотипных серверов. То, что все одинаковое, экономит Facebook деньги — все взаимозаменяемо и производство/закупка компонентов дешевле.

Facebook активно работает над эффективностью оборудования — и снижением его цены. И "экономит" не значит "уменьшает". В самом первом дата-центре компании в Орегоне около 1500 километров проводов и всевозможных кабелей.

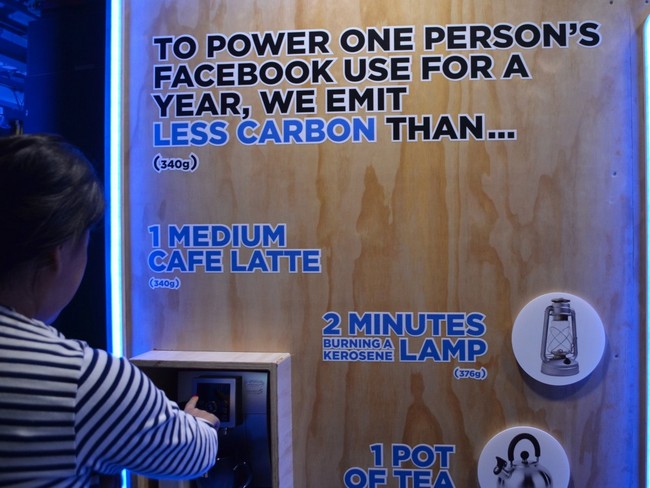

Все эти серверы довольно эффективны в плане потребления электроэнергии и, соответственно, влияния на атмосферу. Один пользователь за год вынуждает Facebook потратить на свое обслуживание и выбросить в атмосферу меньше углеродного газа, чем нужно на приготовление чаши латте.

Если техникам надо провести диагностику отдельного сервера или заменить что-то — они никуда его не несут, вся работа происходит на специальных мобильных станциях.

Понятно, что серверы и прочее оборудование генерируют много тепла и их надо охлаждать. Обычно охлаждают или водой, или воздухом. В дата-центре в Швеции, например, охлаждение сугубо воздушное.

Воздух проходит через множество фильтров и попадает в "туманную комнату", где специальные установки особым образом готовят его, регулируя не только температуру, но и влажность.

Причем в процессе регулирования температуры подающегося в комнаты воздуха участвует и теплый воздух, уже нагретый серверами (это нужно холодной шведской зимой, например). Помещения, в котором воздушные потоки встречаются и "разводятся по углам" находятся над серверными залами, что логично — теплый воздух поднимается вверх, холодный опускается вниз.

Теперь, когда в следующий раз зайдете на Facebook (чтобы поделиться этой статьей, например), вы будете лучше представлять себе, какие огромные и сложные механизмы стоят за простыми вроде бы "лайками" или просмотром ленты друзей. Кстати, ежесуточно четыре дата-центра Facebook обрабатывают 10 триллионов(!) запросов пользователей — от "лайка" до создания поста.